Capítulo 3 Modelo meteorológico

En el análisis hidrológico de una cuenca, el estudio de los datos climatológicos es fundamental para dimensionar adecuadamente la precipitación que alimenta la red de drenaje. La serie temporal de interés en este caso es la de valores mensuales de la precipitación máxima en 24 horas, ya que esta variable es la más ampliamente disponible según la Comisión Nacional del Agua (CONAGUA 1987). Esta variable sirve como entrada en el modelo hidrológico para simular el ciclo hidrológico y predecir el suministro de agua en la región. Debido a la naturaleza aleatoria de la precipitación, es necesario abordar el ciclo hidrológico desde un enfoque probabilístico.

A fin de generar un modelo probabilístico robusto, se han estudiado diferentes metodologías para el tratamiento de series temporales de datos climatológicos, con el propósito de homogeneizar los datos, identificar y tratar valores faltantes y atípicos. En este contexto, RStudio se presenta como una herramienta valiosa, ya que permite explorar las metodologías propuestas por diversos autores, aprovechando el poder computacional del software estadístico.

Para el trabajo con los datos climatológicos, se ha decidido utilizar la librería climatol (Guijarro 2024), debido a que se basa en las guías de homogeneización establecidas por la Organización Meteorológica Mundial y ha sido referenciada en comunidades de hidrólogos.

En cuanto a la selección de las distribuciones probabilísticas de los eventos hidrológicos futuros, se utiliza principalmente la librería nsRFA (Viglione et al. 2023), ya que ofrece una colección de herramientas estadísticas para la aplicación objetiva (no supervisada) de los métodos de Análisis de Frecuencia Regional en Hidrología. En otras palabras, permite al hidrólogo ajustar funciones de distribución a las curvas de crecimiento regionales empíricas haciendo uso de modelos de aprendizaje automático.

En los últimos años, se han realizado numerosos estudios en diferentes países sobre el análisis regional de frecuencias de precipitaciones (Domínguez et al. 2018). Por tanto, el uso de estas aplicaciones no supervisadas puede ser de gran valor para la creación de modelos probabilísticos que permitan estimar de manera confiable las tormentas de diseño, contribuyendo así a una gestión eficiente y sostenible de los recursos hídricos en la cuenca.

3.1 Selección de estaciones climatológicas

En el proceso de modelación hidrológica, la selección adecuada de estaciones climatológicas es crucial para garantizar la calidad y representatividad de los datos de precipitación utilizados. En el presente estudio, el criterio para determinar la cantidad de estaciones a considerar se fundamenta en las recomendaciones de la librería climatol, la cual sugiere el uso de al menos seis estaciones para obtener mejores resultados en la homogeneización de los datos climatológicos.

Afortunadamente, la zona de estudio cuenta con un número suficiente de estaciones climatológicas para cumplir con este criterio. Las tablas con los datos climatológicos de las seis estaciones seleccionadas fueron descargadas del portal de CONAGUA e importadas en RStudio para ser tratadas mediante las funciones de la librería climatol.

La selección de estaciones climatológicas representativas es un paso crucial en el análisis hidrológico, ya que los datos de precipitación obtenidos servirán como entrada en el modelo hidrológico para simular el ciclo hidrológico y predecir el suministro de agua en la región. Una adecuada cobertura espacial de las estaciones garantiza que se capturen las variaciones locales en los patrones de precipitación, lo cual es esencial para obtener estimaciones precisas de los caudales y volúmenes de escorrentía.

Además de la cantidad de estaciones, es importante considerar otros factores como la distribución espacial, la longitud y calidad de los registros históricos, y la presencia de posibles fuentes de error o inconsistencias en los datos. La aplicación de técnicas de homogeneización, como las proporcionadas por la librería climatol, permiten identificar y tratar valores atípicos o faltantes, mejorando la confiabilidad de los datos utilizados en el modelo hidrológico.

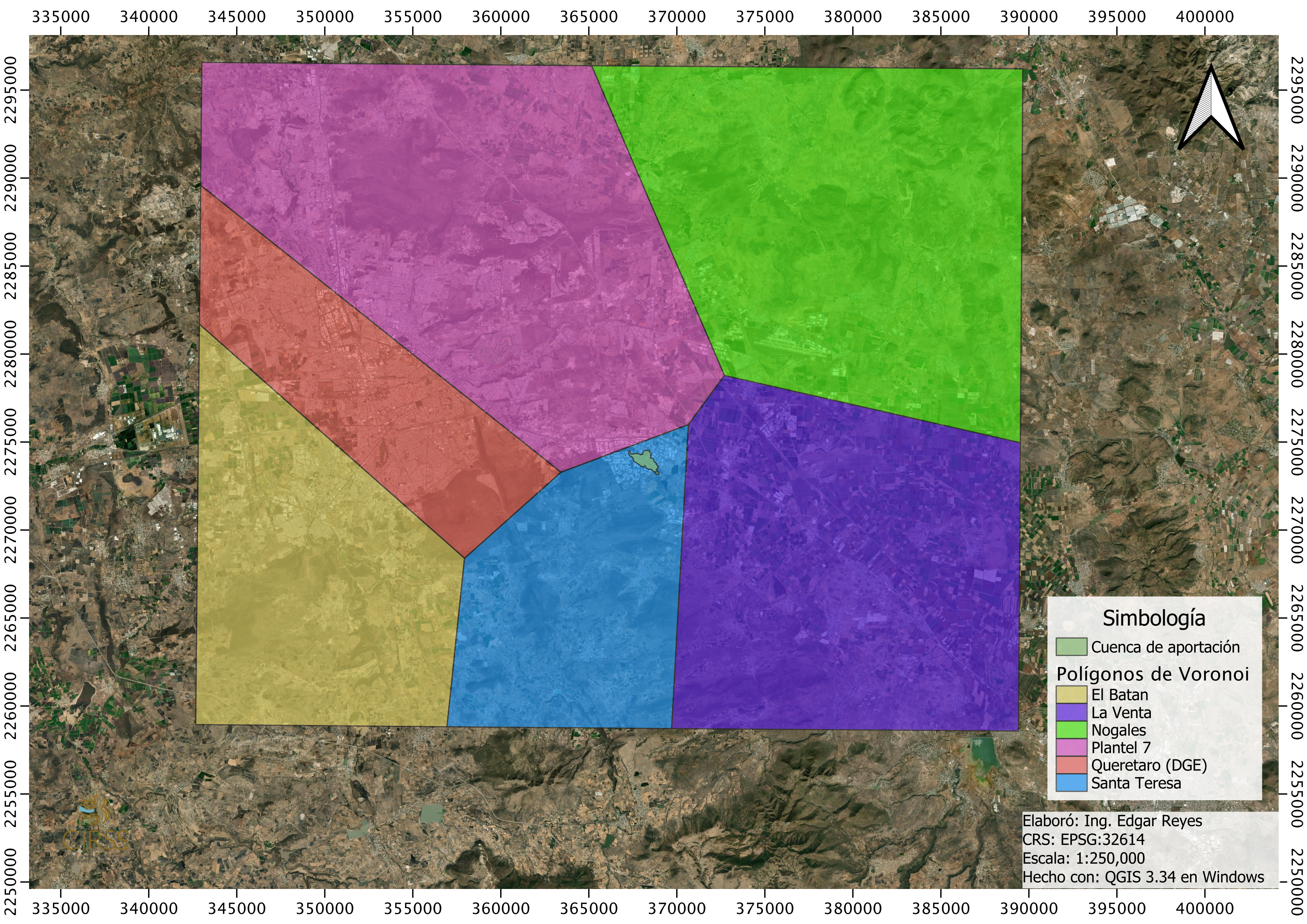

Se usan los polígonos de Voronoi para determinar que estación es la que se va a usar después de que se haya homogenizado, haciendo uso de 5 estaciones adicionales para homogenizar los datos de la estación Santa Teresa, que es la que según los polígonos de Voronoi tiene influencia sobre el predio.

Figura 3.1: Polígonos de Voronoi para seleccionar la estación de influencia en la zona de estudio

Se muestra una extracción de la tabla 3.1 con las precipitaciones extremas de la estación de Santa Teresa . Las 6 tablas originales se encuentran en el Apéndice del Modelo Meteorológico.

| AÑO | ENE | FEB | MAR | ABR | MAY | JUN | JUL | AGO | SEP | OCT | NOV | DIC |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1982 | 0 | 1 | 0 | 7 | 20.0 | 8.0 | 17.0 | 28.0 | 8.0 | 14 | 0 | 6 |

| 1983 | 7 | 0 | 20 | 0 | 13.0 | 71.0 | 24.0 | 65.0 | 6.5 | 16 | 24 | 0 |

| 1984 | 0 | 5 | 0 | 0 | 17.0 | 20.0 | 45.1 | 19.0 | NA | 8 | 0 | 0 |

| 1985 | 0 | 0 | 0 | 18 | 36.0 | 33.0 | 94.0 | 40.0 | 7.0 | 16 | 0 | 5 |

| 1986 | 0 | 0 | 0 | 9 | 7.0 | 47.0 | 33.0 | 26.0 | 47.0 | 50 | 18 | 14 |

| 1987 | 0 | 0 | 3 | 5 | 5.0 | 4.4 | 42.0 | NA | 20.0 | 0 | 12 | 0 |

| 1988 | 6 | 0 | 3 | 2 | 0.0 | 36.0 | 39.0 | 58.0 | 19.0 | 0 | 0 | 0 |

| 1989 | 0 | 4 | 0 | 7 | 28.0 | 31.0 | 30.0 | 31.0 | 18.0 | 0 | 0 | 0 |

| 1990 | 0 | 0 | 6 | 4 | NA | 0.0 | 23.0 | 34.0 | 17.0 | 18 | 0 | 0 |

| 1991 | 0 | 0 | 0 | 0 | 5.7 | 20.0 | 90.0 | 33.5 | 30.0 | 5 | 0 | 4 |

3.2 Homogenización de datos climatológicos

Se tiene que preparar la información para presentarla conforme los requerimientos de las funciones de la librería climatol.

La función csv2climatol ocupa un archivo con el código de las estaciones, sus coordenadas geográficas en decimales y su nombre; y otro archivo con los datos climatológicos.

Para este segundo archivo, el algoritmo toma los archivos de cada estación en formato csv, borra los años que tengan al menos una NA y genera un archivo único.

La metodología estadística usada para la homogenización de datos es la Standard Normal Homogeneity Test (SNHT) que usa la siguiente expresión para calcular la prueba estadística.

\[ T_k = k z_1^2 + \left(n - k\right) z_2^2 \qquad (1 \le k < n) \]

donde

\[ \begin{array}{l l} z_1 = \frac{1}{k} \sum_{i=1}^k \frac{x_i - \bar{x}}{\sigma} & z_2 = \frac{1}{n-k} \sum_{i=k+1}^n \frac{x_i - \bar{x}}{\sigma}. \\ \end{array} \]

El valor crítico es:

\[T = \max T_k\]

El algoritmo realiza una serie de pasos y presenta parámetros estadigráficos de la prueba, el error cuadrático medio del valor estimado, el porcentaje de los datos originales, las anomalías presentes en los diferentes intervalos de confianza y el rango derecho del intervalo de confianza para la prueba estadística. El algoritmo también genera archivos que se pueden usar para cálculos posteriores, así como un reporte de los diferentes resultados que genera el proceso de homogenización de datos como el control de calidad de las series, el resumen de los datos disponibles, gráficos de detección y corrección de anomalías, etc.

De las estaciones climatológicas se usan los años de 1983 a 2019, pues en casi todas las estaciones incluyen este rango de años.

HOMOGEN() APPLICATION OUTPUT (From R's contributed package 'climatol' 4.1.0)

=========== Homogenization of precipitacion, 1983-2019. (Sat Jun 8 21:24:50 2024)

Parameters: varcli=precipitacion, anyi=1983, anyf=2019, test=snht, nref=10 10 4, std=NA, swa=NA, ndec=1, niqd=4 1, dz.max=0.01, dz.min=-0.01, cumc=NA, wd=0 0 100, inht=25, sts=5, maxdif=0.05, maxite=999, force=FALSE, wz=0.001, mindat=NA, onlyQC=FALSE, annual=mean, ini=NA, na.strings=NA, vmin=NA, vmax=NA, hc.method=ward.D2, nclust=300, cutlev=NA, grdcol=#666666, mapcol=#666666, expl=FALSE, metad=FALSE, sufbrk=m, tinc=NA, tz=utc, rlemin=NA, rlemax=NA, cex=1.1, uni=NA, raway=TRUE, graphics=TRUE, verb=TRUE, logf=TRUE, snht1=NA, snht2=NA, gp=NA

Data matrix: 444 data x 6 stations

Warning: excessive run lengths diagnostic skiped because IQR=0

-------------------------------------------

Stations in the 2 clusters :

$`1`

[1] 1 2 3 4 5

$`2`

[1] 6

---------------------------------------------

Computing inter-station distances ... 1 2 3 4 5

========== STAGE 1 (SNHT on overlapping temporal windows) ===========

Calculation of missing data with outlier removal

(Suggested data replacements are provisional)

Station(rank) Date: Observed -> Suggested (Anomaly, in std. devs.)

22004(5) 2009-09-01: 33.4 -> 120.2 (-5.44)

22046(6) 2017-02-01: 145.6 -> 3.1 (9.39)

Performing shift analysis on the 6 series...

========== STAGE 2 (SNHT on the whole series) =======================

Calculation of missing data with outlier removal

(Suggested data replacements are provisional)

Station(rank) Date: Observed -> Suggested (Anomaly, in std. devs.)

(No detected outliers)

Performing shift analysis on the 6 series...

22067(2) breaks at 2017-05-01 (27.4)

Update number of series: 6 + 1 = 7

Calculation of missing data with outlier removal

(Suggested data replacements are provisional)

Station(rank) Date: Observed -> Suggested (Anomaly, in std. devs.)

(No detected outliers)

Performing shift analysis on the 7 series...

========== STAGE 3 (Final calculation of all missing data) ==========

Computing inter-station weights... (done)

Calculation of missing data with outlier removal

(Suggested data replacements are provisional)

The following lines will have one of these formats:

Station(rank) Date: Observed -> Suggested (Anomaly, in std. devs.)

Iteration Max_data_difference (Station_code)

2 0.573 (22067-2)

3 0.275 (22067-2)

4 0.14 (22067)

5 0.127 (22067)

6 0.116 (22067)

7 0.107 (22067)

8 0.099 (22067)

9 0.092 (22067)

10 0.086 (22067-2)

11 0.082 (22067-2)

12 0.077 (22067-2)

13 0.072 (22067-2)

14 0.068 (22067-2)

15 0.064 (22067-2)

16 0.06 (22067-2)

17 0.056 (22067-2)

18 0.052 (22067-2)

19 0.049 (22067-2)

Prescribed convergence reached

Last series readjustment (please, be patient...)

======== End of the homogenization process, after 1.91 secs

----------- Final calculations :

SNHT: Standard normal homogeneity test (on anomaly series)

Min. 1st Qu. Median Mean 3rd Qu. Max.

5.600 6.400 8.200 8.643 9.650 14.600

RMSE: Root mean squared error of the estimated data

Min. 1st Qu. Median Mean 3rd Qu. Max.

3.674 12.597 13.944 12.549 14.724 15.585

POD: Percentage of original data

Min. 1st Qu. Median Mean 3rd Qu. Max.

7.00 55.00 66.00 60.43 70.50 99.00

SNHT RMSE POD Code Name

1 7.2 13.9 75 22058 Santa Teresa

2 8.2 3.7 7 22067 La Venta

3 14.6 14.1 66 22063 Queretaro (DGE)

4 5.6 15.3 56 22070 Plantel 7

5 5.6 15.6 99 22004 El Batan

6 9.5 12.6 66 22046 Nogales

7 9.8 12.6 54 22067-2 La Venta-2

Frequency distribution tails of residual anomalies and SNHT

Left tail of standardized anomalies:

0.1% 0.2% 0.5% 1% 2% 5% 10%

-4.1 -3.5 -3.0 -2.6 -2.2 -1.5 -1.1

Right tail of standardized anomalies:

90% 95% 98% 99% 99.5% 99.8% 99.9%

1.0 1.7 2.7 3.4 3.9 4.5 5.3

Right tail of SNHT on windows of 120 terms with up to 4 references:

90% 95% 98% 99% 99.5% 99.8% 99.9%

21.9 24.1 25.4 25.9 26.1 26.2 26.3

Right tail of SNHT with up to 4 references:

90% 95% 98% 99% 99.5% 99.8% 99.9%

11.7 13.2 14.0 14.3 14.5 14.5 14.6

----------- Generated output files: -------------------------

precipitacion_1983-2019.txt : Text output of the whole process

precipitacion_1983-2019_out.csv : List of corrected outliers

precipitacion_1983-2019_brk.csv : List of corrected breaks

precipitacion_1983-2019.pdf : Diagnostic graphics

precipitacion_1983-2019.rda : Homogenization results. Postprocess with (examples):

dahstat('precipitacion',1983,2019) # averages

dahstat('precipitacion',1983,2019,stat='tnd') #OLS trends and p-values

dahstat('precipitacion',1983,2019,stat='series') #homogenized series

dahgrid('precipitacion',1983,2019,grid=YOURGRID) #homogenized grids

... (See other options in the package documentation)Se extrae uno de los archivos generados por la función para poder construir la tabla de estaciones con los datos climatológicos homogenizados 3.2.

| Year | X22058 | X22067 | X22063 | X22070 | X22004 | X22046 | X22067.2 |

|---|---|---|---|---|---|---|---|

| 1983 | 71.0 | 11.1 | 61.9 | 55.2 | 55.8 | 56.3 | 49.7 |

| 1984 | 45.1 | 4.7 | 60.3 | 48.8 | 70.5 | 46.5 | 21.0 |

| 1985 | 94.0 | 10.6 | 88.9 | 52.8 | 60.8 | 51.8 | 47.1 |

| 1986 | 50.0 | 11.4 | 67.0 | 59.9 | 64.8 | 54.4 | 51.0 |

| 1987 | 42.0 | 9.4 | 47.8 | 42.7 | 46.2 | 37.7 | 41.8 |

| 1988 | 58.0 | 10.3 | 43.7 | 43.8 | 46.5 | 30.6 | 46.0 |

| 1989 | 31.0 | 18.1 | 46.2 | 49.9 | 90.6 | 32.5 | 81.0 |

| 1990 | 34.0 | 7.8 | 34.6 | 38.8 | 54.5 | 36.9 | 34.9 |

| 1991 | 90.0 | 10.5 | 55.8 | 68.0 | 74.3 | 49.6 | 47.0 |

| 1992 | 20.4 | 9.0 | 47.5 | 30.5 | 66.4 | 21.1 | 40.0 |

| 1993 | 13.5 | 9.4 | 40.0 | 31.4 | 61.2 | 22.0 | 42.0 |

| 1994 | 23.5 | 7.8 | 30.7 | 23.1 | 37.5 | 16.2 | 35.0 |

| 1995 | 66.0 | 4.7 | 60.0 | 45.9 | 60.3 | 52.8 | 21.0 |

| 1996 | 56.3 | 8.1 | 57.9 | 49.5 | 58.8 | 81.4 | 36.0 |

| 1997 | 60.5 | 9.5 | 35.7 | 50.0 | 34.8 | 29.2 | 42.2 |

| 1998 | 62.5 | 9.3 | 52.4 | 53.0 | 61.5 | 25.8 | 41.6 |

| 1999 | 60.5 | 7.7 | 42.4 | 93.5 | 36.3 | 48.0 | 34.2 |

| 2000 | 65.6 | 8.5 | 51.9 | 54.0 | 23.7 | 40.0 | 38.0 |

| 2001 | 65.0 | 12.7 | 75.5 | 56.5 | 79.7 | 49.6 | 56.5 |

| 2002 | 30.0 | 10.3 | 80.0 | 66.9 | 53.6 | 40.0 | 46.0 |

| 2003 | 70.0 | 13.0 | 84.7 | 92.0 | 96.7 | 52.9 | 58.0 |

| 2004 | 70.0 | 11.2 | 61.1 | 72.4 | 79.6 | 45.3 | 50.0 |

| 2005 | 40.0 | 7.4 | 55.6 | 69.0 | 48.6 | 42.8 | 33.0 |

| 2006 | 60.0 | 13.4 | 62.3 | 70.4 | 132.5 | 39.4 | 60.0 |

| 2007 | 39.0 | 9.9 | 50.5 | 49.2 | 62.6 | 34.5 | 44.0 |

| 2008 | 31.1 | 7.9 | 50.3 | 40.1 | 57.4 | 27.4 | 35.0 |

| 2009 | 81.4 | 20.6 | 85.9 | 128.9 | 120.4 | 72.4 | 92.0 |

| 2010 | 42.1 | 10.8 | 62.0 | 104.4 | 62.7 | 63.3 | 48.2 |

| 2011 | 38.6 | 9.8 | 69.5 | 51.0 | 56.7 | 34.4 | 43.6 |

| 2012 | 37.8 | 9.6 | 46.5 | 60.5 | 56.0 | 33.7 | 42.8 |

| 2013 | 39.6 | 10.1 | 56.1 | 74.5 | 53.0 | 35.8 | 45.0 |

| 2014 | 33.3 | 8.4 | 67.5 | 60.0 | 41.5 | 29.8 | 37.7 |

| 2015 | 20.0 | 13.4 | 94.7 | 80.5 | 82.0 | 30.8 | 60.0 |

| 2016 | 60.0 | 19.3 | 67.1 | 69.0 | 42.0 | 47.3 | 86.0 |

| 2017 | 65.0 | 17.6 | 88.0 | 32.3 | 75.0 | 28.2 | 78.6 |

| 2018 | 50.0 | 10.9 | 39.5 | 22.5 | 52.0 | 55.4 | 48.7 |

| 2019 | 30.0 | 10.0 | 76.9 | 23.6 | 47.0 | 47.3 | 44.6 |

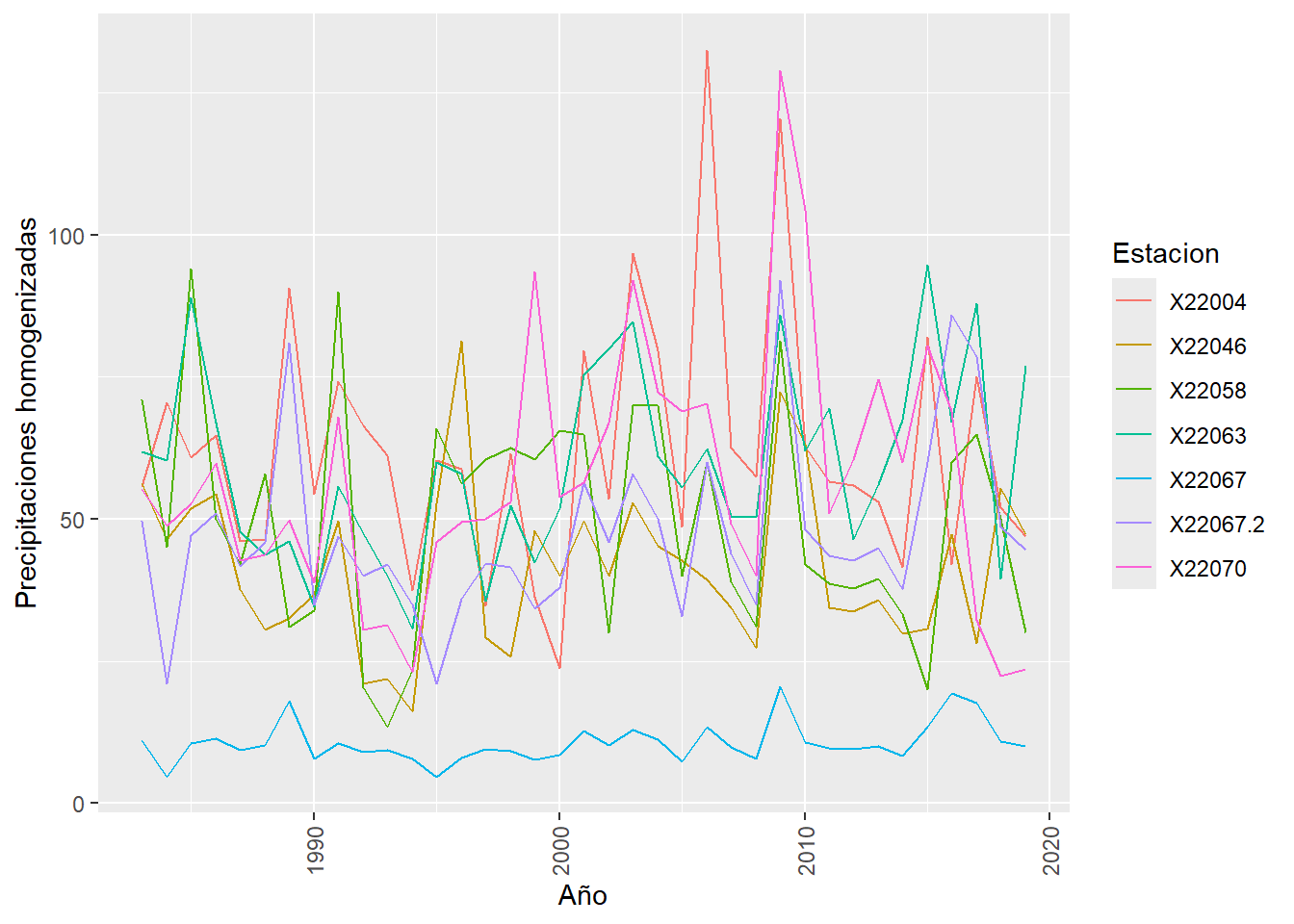

Se genera el gráfico 3.2 para visualizar la distribución temporal de los datos climatológicos de las 6 estaciones homogenizadas.

Figura 3.2: Distribución de precipitaciones homogenizadas

Se ha optado por aplicar la prueba de \(X\)2 para la prueba de independencia a los datos climatológicos homogenizados, en donde, para determinar que las muestras son independientes se revisa p>0.05.

$X22058

Pearson's Chi-squared testdata: contingency_table X-squared = 1110, df = 1080, p-value = 0.2566

$X22067

Pearson's Chi-squared testdata: contingency_table X-squared = 1147, df = 1116, p-value = 0.2533

$X22063

Pearson's Chi-squared testdata: contingency_table X-squared = 1332, df = 1296, p-value = 0.2377

$X22070

Pearson's Chi-squared testdata: contingency_table X-squared = 1295, df = 1260, p-value = 0.2407

$X22004

Pearson's Chi-squared testdata: contingency_table X-squared = 1332, df = 1296, p-value = 0.2377

$X22046

Pearson's Chi-squared testdata: contingency_table X-squared = 1221, df = 1188, p-value = 0.2468

$X22067.2

Pearson's Chi-squared testdata: contingency_table X-squared = 1184, df = 1152, p-value = 0.25

Conforme a los resultados de las pruebas de independencia se puede decir que las muestras son independientes.

3.3 Funciones de las distribuciones probabilísticas de las estaciones climatológicas

En el ámbito de la hidrología, existen diversas funciones de distribución de probabilidad que se han empleado con éxito para modelar eventos hidrológicos extremos, como las precipitaciones máximas. Entre las funciones más comúnmente utilizadas se encuentran: Normal, Log-Normal, Exponencial, Gamma, Pearson tipo III (o Gamma de tres parámetros), Log-Pearson tipo III y de valores extremos (VE tipos I, II y III; o respectivamente Gumbel, Frechet y Weibull).

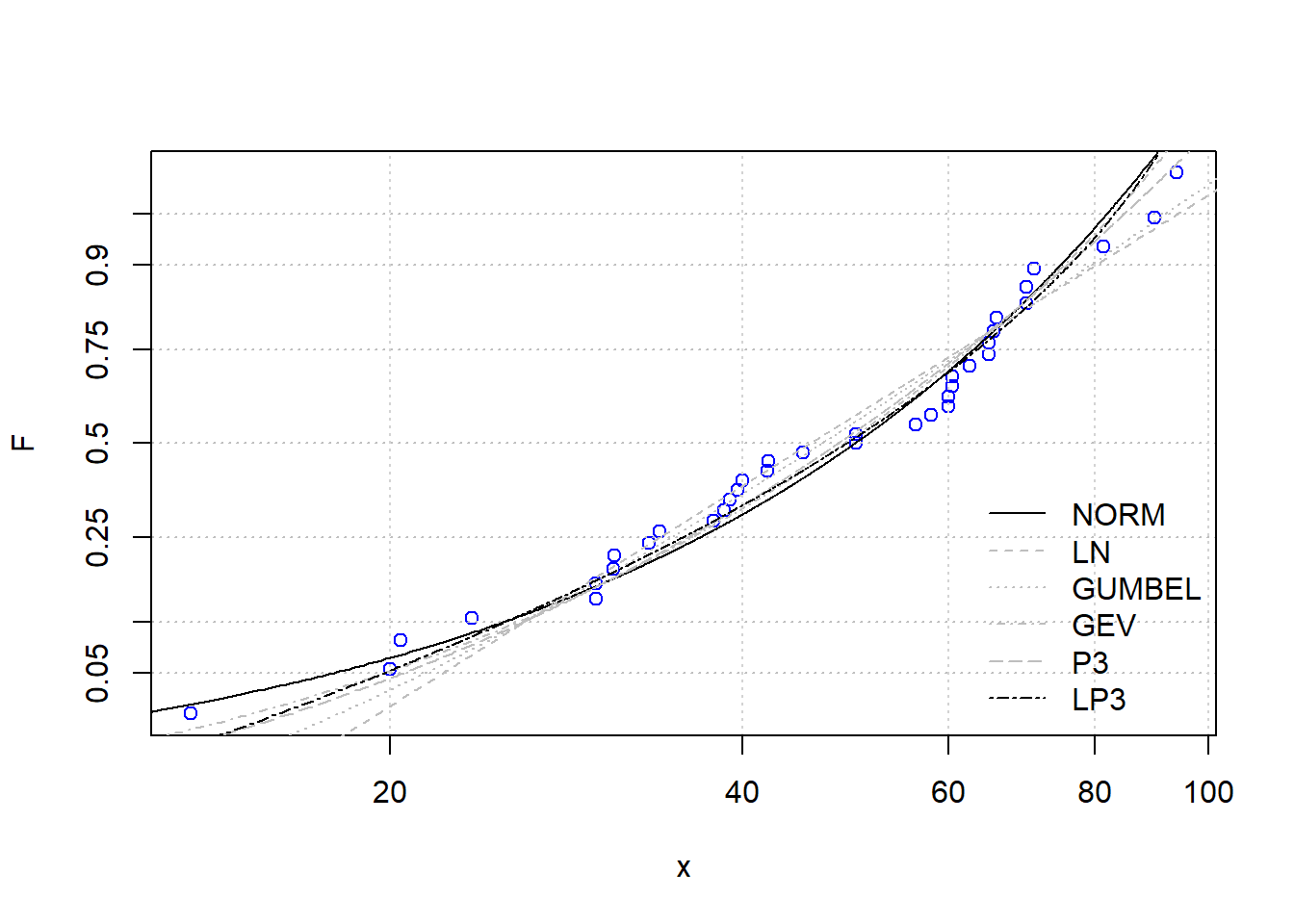

En este estudio se comparan las funciones Normal, Log-Normal, Gumbel, Pearson 3 parámetros, Log Pearson 3 parámetros y de Valor Extremo Generalizado por 3 parámetros, haciendo uso de las funciones de nsRFA.

Citando la documentación de nsRFA: “El problema de la selección de modelos se puede formalizar de la siguiente manera: se dispone de una muestra de n datos, \(D = (x~1~, ..., x~n~)\), ordenados de manera ascendente, muestreados de una distribución parental desconocida f(x); se utilizan Nm modelos operativos, \(M~j~, j = 1, ...\), Nm, para representar los datos. Los modelos operativos son en forma de distribuciones de probabilidad, Mj = gj(x, \(\hat{\theta}\)), con parámetros \(\hat{\theta}\) estimados a partir de la muestra de datos disponible D. El objetivo de la selección de modelos es identificar el modelo Mopt que mejor se adapta para representar los datos, es decir, el modelo que está más cercano en algún sentido a la distribución parental f(x). Aquí se consideran tres criterios diferentes de selección de modelos, a saber, el Criterio de Información de Akaike (AIC), el Criterio de Información Bayesiano (BIC) y el Criterio de Anderson-Darling (ADC). De los tres métodos, los dos primeros pertenecen a la categoría de enfoques clásicos de la literatura, mientras que el tercero se deriva de una interpretación heurística de los resultados de una prueba estándar de bondad de ajuste.” (Viglione et al. 2023)

El algoritmo grafica la función de la distribución empírica de la muestra (posición de trazado de Weibull) en una gráfica de probabilidad log-normal, y grafica las distribuciones candidatas (cuyos parámetros se evalúan con la técnica de máxima verosimilitud).

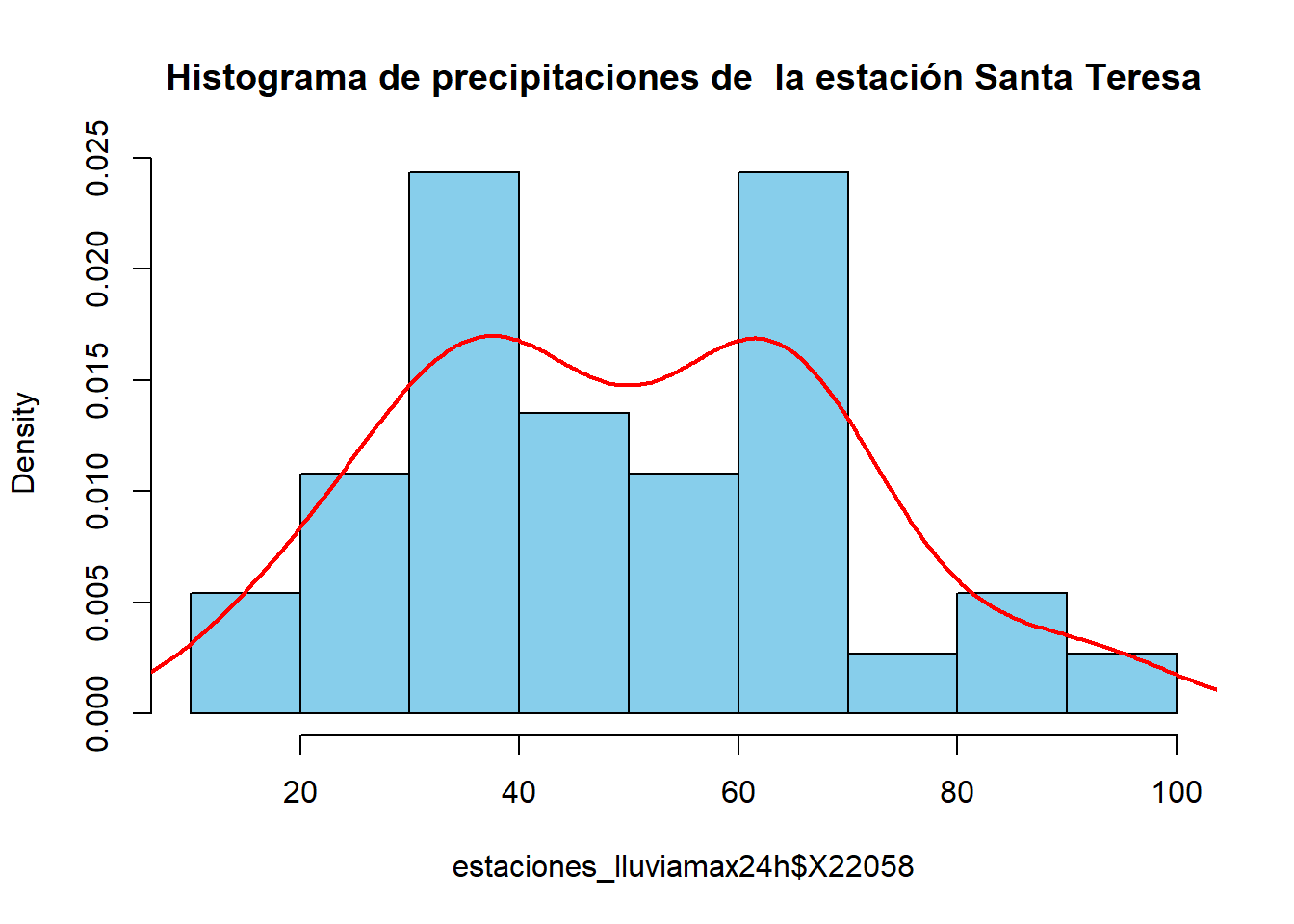

Para cada estación se documenta:

- histograma,

- los resultados de la función MSClaio2008 de la librería nsRFA (Viglione et al. 2023) y

- la tabla con las distribuciones de eventos extremos para diferentes períodos de retorno.

En este capítulo, se presentará la información completa de una estación climatológica como ejemplo. Para el resto de las estaciones solo se presenta la tabla con la distribución de probabilidad ajustada a los parámetros de la función recomendada por MSClaio2008. La información completa de las 5 estaciones restantes se encuentra en el Apéndice del Modelo Meteorológico.

Se presenta la información de la estación Santa Teresa.

------------------------

Akaike Information Criterion (AIC):

NORM LN GUMBEL P3 LP3 GEV

328.7 331.1 329.6 329.9 328.7 329.7

------------------------

Corrected Akaike Information Criterion (AICc):

NORM LN GUMBEL P3 LP3 GEV

329.0 331.4 330.0 330.7 329.4 330.4

------------------------

Bayesian Information Criterion (BIC):

NORM LN GUMBEL P3 LP3 GEV

331.9 334.3 332.9 334.8 333.5 334.5

------------------------

Anderson-Darling Criterion (ADC):

NORM LN GUMBEL P3 LP3 GEV

0.1830 0.3296 0.2158 0.2333 0.1452 0.2063

Tested distributions:

[1] NORM LN GUMBEL P3 LP3 GEV

------------------------

Chosen distributions:

AIC AICc BIC ADC

LP3 NORM NORM LP3

whose Maximum-Likelihood parameters are:

NORM parameters of x: 49.91351 19.46211

P3 parameters of log(x): 4.758897 -0.2155336 4.342562

| Tr | Precipitación_SantaTeresa_Gumbell | Precipitación_SantaTeresa_Normal | Precipitación_SantaTeresa_LP3mom | Precipitación_SantaTeresa_LP3mv |

|---|---|---|---|---|

| 2 | 46.4695 | 49.9135 | 48.9239 | 49.0927 |

| 5 | 64.9972 | 66.2932 | 67.5200 | 67.0844 |

| 10 | 77.2642 | 74.8552 | 77.1786 | 76.1699 |

| 20 | 89.0310 | 81.9258 | 84.7886 | 83.1752 |

| 25 | 92.7635 | 83.9856 | 86.9152 | 85.1053 |

| 50 | 104.2618 | 89.8838 | 92.7294 | 90.3135 |

| 100 | 115.6752 | 95.1891 | 97.5652 | 94.5594 |

| 200 | 127.0470 | 100.0446 | 101.6289 | 98.0578 |

| 500 | 142.0499 | 105.9286 | 106.0626 | 101.7900 |

| 1000 | 153.3887 | 110.0560 | 108.8443 | 104.0792 |

| 5000 | 179.7041 | 118.8110 | 113.8586 | 108.0804 |

| 10000 | 191.0356 | 122.2934 | 115.5307 | 109.3713 |

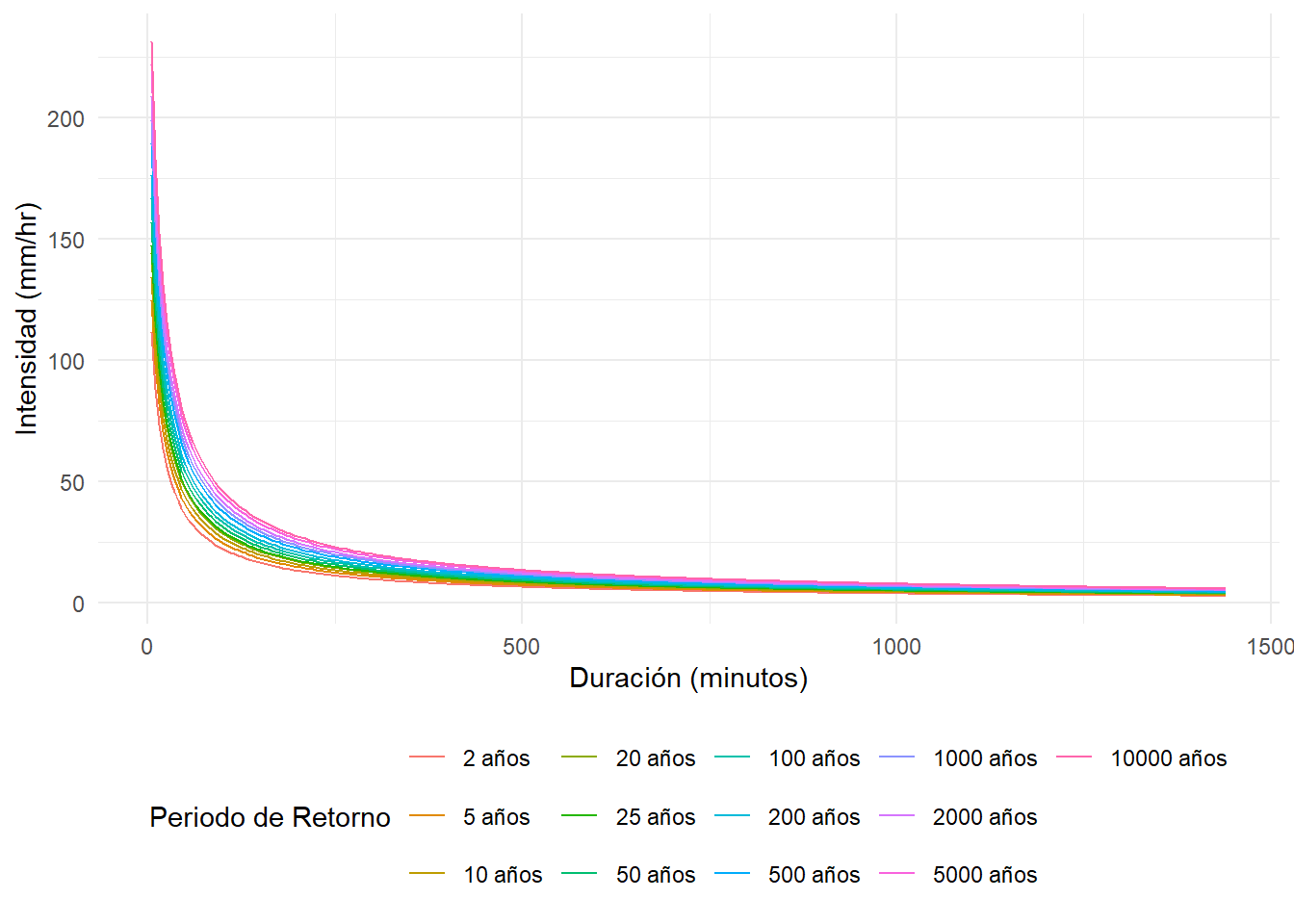

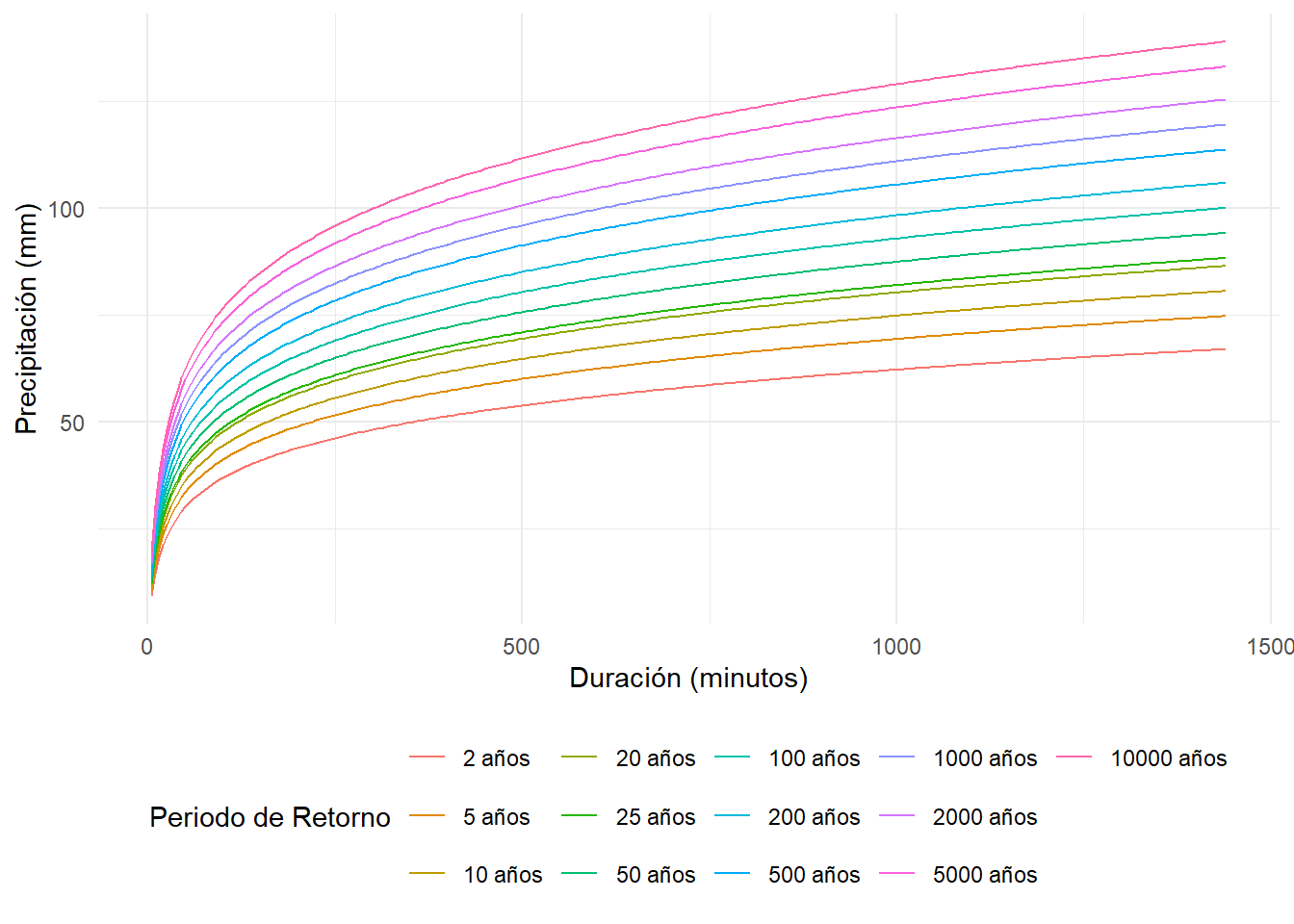

3.4 Curvas IDTR y PDTR

En el análisis hidrológico, las características de las precipitaciones se definen mediante tres variables: magnitud o lámina, duración y frecuencia. La magnitud de lluvia se refiere a la precipitación total ocurrida (en milímetros) durante la duración de la tormenta, mientras que la frecuencia se expresa como el período de retorno, el cual representa el tiempo promedio en años en el que un evento puede ser igualado o excedido, al menos una vez, en promedio (Daniel Francisco Campos Aranda 1990).

Las curvas Intensidad-Duración-Período de Retorno (IDTR) son herramientas gráficas que permiten definir las características de las tormentas en una región específica, considerando las variables mencionadas.

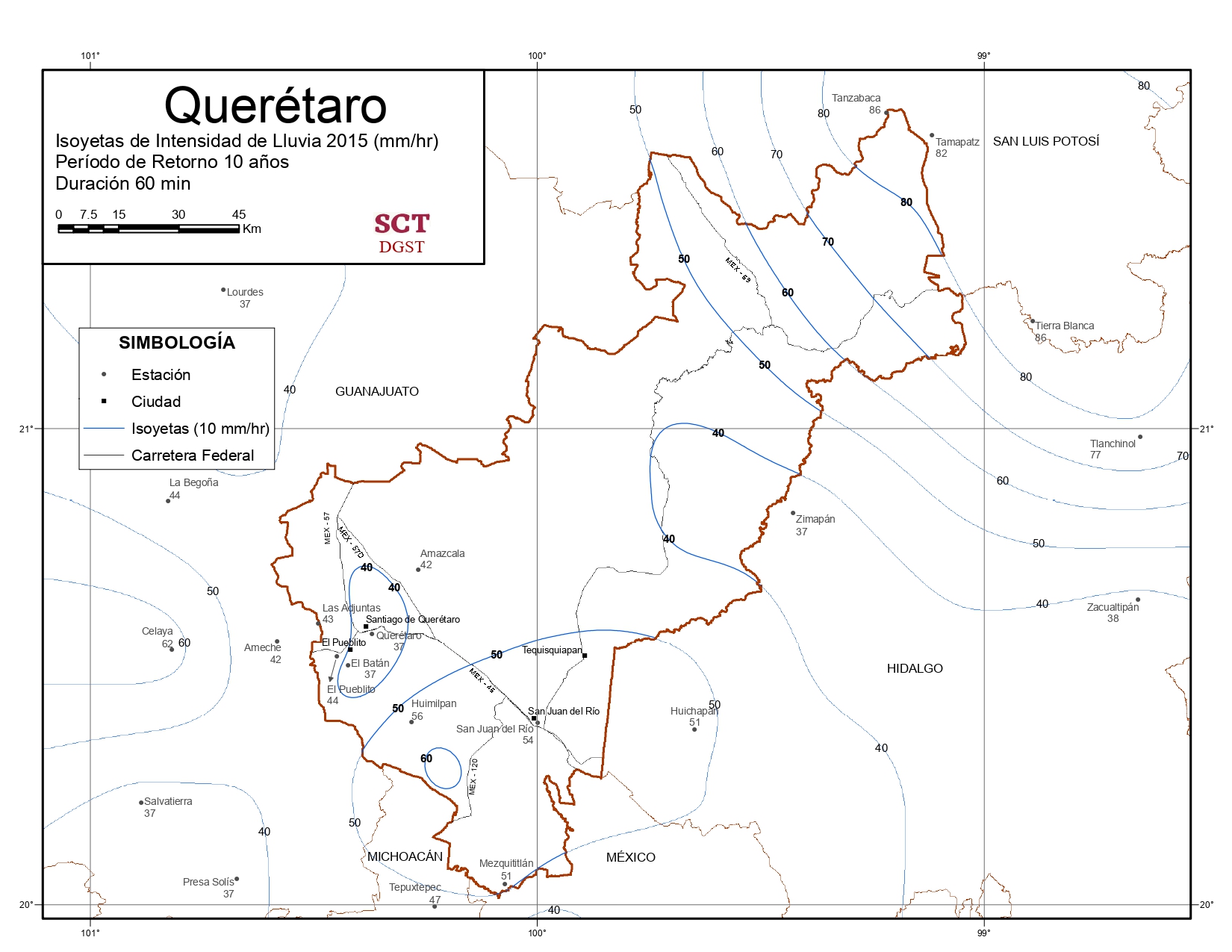

Para obtener las curvas IDTR, es necesario transformar los datos de precipitación máxima en 24 horas a precipitaciones de diferentes duraciones y períodos de retorno. Debido a la escasez de registros de lluvia de corta duración, ha surgido la necesidad de utilizar las relaciones promedio entre lluvias encontradas en otros países (Daniel Francisco Campos Aranda 1990). La Secretaría de Comunicaciones y Transportes (SCT) ha documentado estas relaciones en forma de isoyetas, las cuales permiten representar cartográficamente los puntos terrestres que comparten el mismo indicador de pluviosidad media anual.

Figura 3.3: Ejemplo del uso de las isoyetas para calcular las precipitaciones asociadas al Tr

Para el cálculo de las curvas de Intensidad - Duración - Tiempo de Retorno se usa la metodología de Chen modificado.

Se importan a RStudio las capas vectoriales de la cuenca cortadas por mapas de Isoyetas (las vigentes datan del año 2015). Estos mapas de isoyetas se han georeferenciado para poder usar las herramientas de QGIS y superponer la cuenca para obtener la pluviosidad asociada a la cuenca.

Se localizan las intensidades con duración de 60 minutos para los periodos de retorno de 10, 25 y 50 años.

P1hr10años: 40 mm/hr

P1hr25años: 50 mm/hr

P1hr50años: 55 mm/hr

Se corrigen las frecuencias por factor de Weiss y se obtienen los diferentes parámetros que se ocupan para el cálculo de la tabla IDTR.

Primero se obteniene Rprom, se debe revisar si cae en rango [0.1-0.6] o [0.2-0.7] para cálculos posteriores.

Rprom: 0.4647273

Dependiendo del rango en el que este Rprom se usan diferentes ecuaciones para obtener los parámetros a,b,c.

Parámetro a: 28.86927

Parámetro b: 9.611515

Parámetro c: 0.8022871

Se obtiene F.

F: 1.241427

Con los parámetros calculados se procede a graficar las curvas IDTR.

Figura 3.4: Gráfico de las curvas Intensidad - Duración - Tiempo de Retorno

Después se hacen los cálculos necesarios para obtener las curvas PDTR. La memoria de cálculo se encuentra en el Apéndice del Modelo Meteorológico.

Figura 3.5: Gráfico de las curvas Precipitación - Duración - Tiempo de Retorno

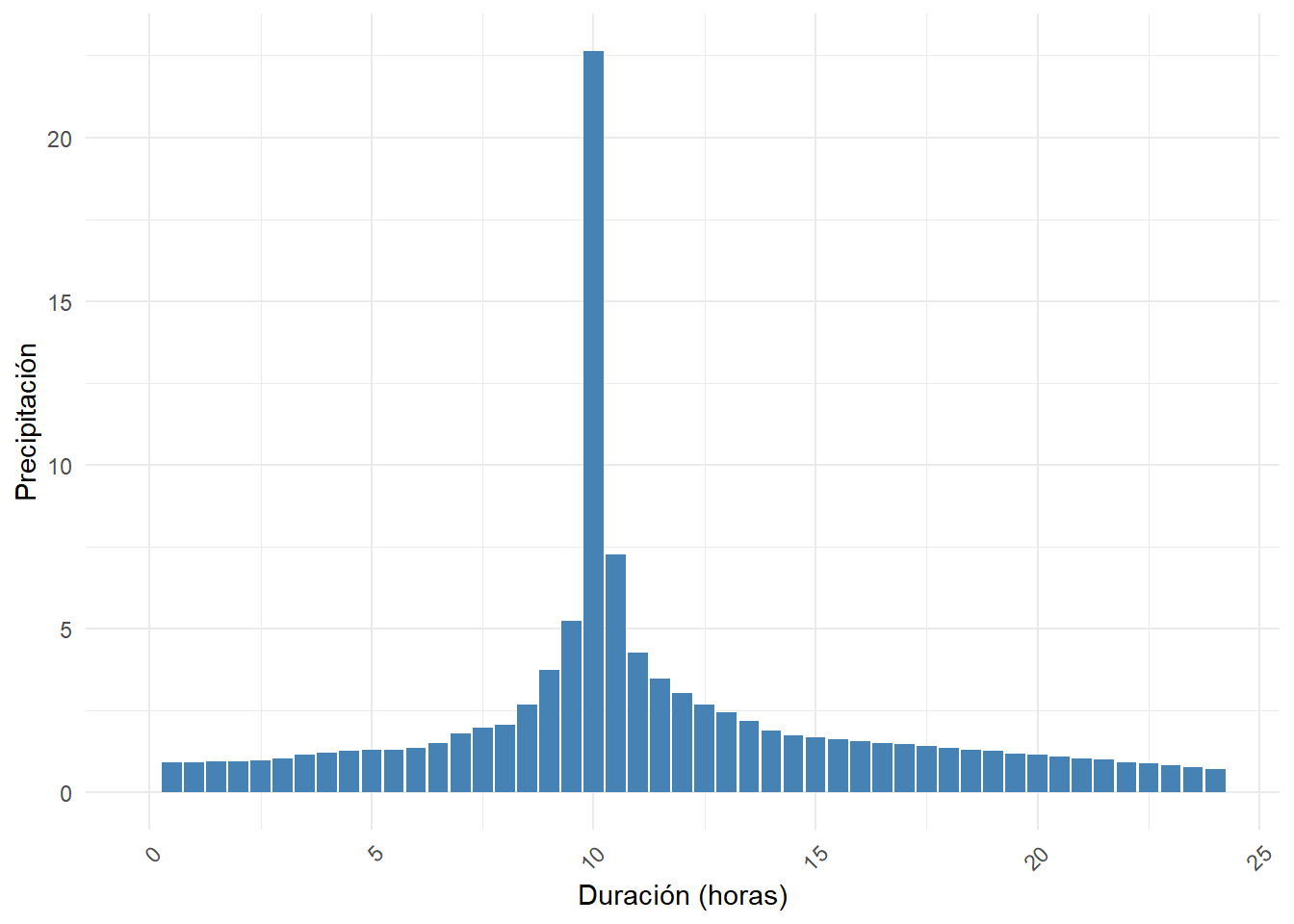

3.5 Hietograma

Cuando no se dispone de registros climáticos e hidrométricos completos, el proceso de conversión de precipitación en escorrentía se aborda mediante la modelación de la tormenta incidente en la cuenca y la fase terrestre del ciclo hidrológico que se desarrolla en ella. En este enfoque, las tormentas de diseño son el punto de partida para las estimaciones hidrológicas de escurrimientos, tanto en cuencas rurales como urbanas, en ausencia de información hidrométrica directa.

Existen dos tipos fundamentales de tormentas de diseño: históricas y sintéticas o hipotéticas. Las tormentas históricas son eventos severos o extraordinarios que han ocurrido en el pasado y fueron registrados, pudiendo estar bien documentados en relación con los problemas y daños causados a las áreas urbanas y sus sistemas de drenaje. Por otro lado, las tormentas sintéticas o hipotéticas se obtienen a partir del estudio y generalización de un gran número de tormentas severas observadas, con el objetivo de estimar un hietograma que represente las características de las tormentas en la zona de estudio (Aranda 2010).

En el presente estudio, se obtendrá el hietograma de diseño utilizando la metodología propuesta por el NRCS. El período de retorno se selecciona con base en en la tabla del Anexo 1 del memorando de CONAGUA de 2017 (CONAGUA 2017). El período de retorno que marca el memorando para el punto de control de la zona de estudio es de 10 años para redes de drenaje de zonas industriales.

(#fig:hietograma, figura-hietograma)Hietograma para el Periodo de Retorno 100 años